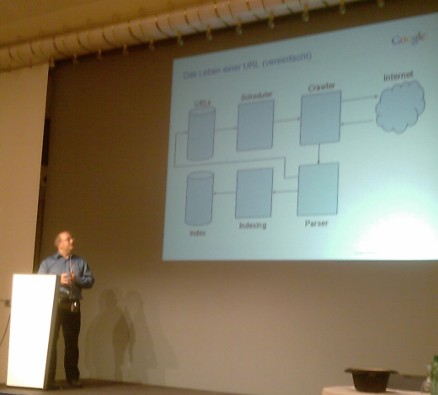

John Mueller, Senior Trends Analyst, Google Schweiz, an der SEO-Konferenz des Internet Briefings im Zürcher Kongresshaus über das Crawlen und Indizieren der Google Search-Engine. Twitter: @JohnMu

URLs werden über folgende Schritte eingelesen: Scheduler, Crawler, Internet, Parser, Indexing, Index

Woher kommen bei Google die URLs?

– Bekannte URLs

– Links

– Sitemaps

– Adressen per AJAX oder JavaScript gefunden

– Andere Quellen

Scheduler

– Welche URL sollen wann gelesen werden?

– Wie viele URLs können gecrawlt werden?

– x Seiten crawlen pro Server / Host / Tag / Nacht

– Wird der Server langsamer, muss der Crawler langsamer lesen

Crawler

– Kontrolle der robots.txt Datei

– URLs lesen

– Fehler melden

– Inhalte weitergeben

Crawling beinhaltet alles vom Finden der URL bis hin zum eigentlichen herunterladen der Inhalte.

Parser

– Inhalte werden untersucht

– Links gefunden

– Text-Inhalte werden erkannt

– Titel, Ãœberschriften werden gelesen

Indexing

– Sollen URLs aufgehoben werden?

– Gibt es Duplicate Content?

Google-Index

– Im Index stehen die Resultate für eine Abfrage bereit

Kontrolle der Indizierung mit Google Webmastertools

– ‹Fetch as Googlebot› holt sich eine bestimmte Seite als wäre es der Google Bot.

– Redirects werden dargestellt

– Wieviele Seiten werden pro Tag gecrawled?

– Bei Shared Hosting wird die Crawling-Intensität über verschiedene Sites gemittelt

– Crawling-Fehler werden als Liste ausgewiesen

Die Robots.txt-Datei wird ca. täglich gelesen. Mit ‹Fetch as Googlebot› kann man sie aktualisieren. Einfache Fehler werden ignoriert. Unerreichbare robots.txt oder ein fünfmaliger vergeblicher Aufruf blockieren das Crawling.

Was, wenn zu «wenig» Seiten indiziert werden?

– Site: -Abfrage abgleichen mit der Anzahl Seiten in der Sitemap

– Sind alle Seiten über Links zugänglich?

– Blockiert die robots.txt-Datei zu viele Verzeichnisse?

Die in der Schweiz üblichen Sprachvarianten befinden sich bei Google im gleichen Index, nicht in sprachgetrennten Indizes. Die sprachangepasste Domain ist weniger wichtig als die effektiven Inhalte. Länderübergreifende Websites sollten allerdings mit entsprechenden Länderdomains geführt werden.

Der ganze Prozess über alle Module dauert Sekunden bis Minuten.

Google hat keine «Sandbox» für neue Domains. Die Search-Engine ist interessiert, möglichst schnell alle relevanten URLs zu präsentieren.

Der Supplemental Index hat stark an Bedeutung verloren: Früher gab es aus technischen Gründen einen Hintergrundindex. Heute werden alle URLs gleich behandelt.

Social Search funktioniert ähnlich, enthält aber weitere Metainformationen: Spezifisch werden Blogs erkannt, Tweets, Social Graph und die Beziehungen zwischen Bloggern und Lesern. Die gefundenen Resultate werden basierend auf Aktualität in die Google Resultatliste eingestreut.